なぜ人工知能には女性への偏見があるのか?

数年前にアマゾンが求職者の履歴書を審査するために最新の自動雇用ツールを使い始めました。しかし、その後まもなく、技術職に応募するための履歴書において、「women’s」という単語が入っているものや女子大学に言及しているものが低く評価されていることに同社は気がつきました。なぜそのようなことになったのでしょうか。答えは、詰まるところ、システムに教えるために使われたデータにあったのです。

アマゾンにこの10年間に提出された、ほとんどが男性の履歴書に基づく、この「最新の」自動システムは実は「昔ながらの」状況を受け継ぎながら、より「なじみのある」応募者を優先して評価していました。

人工知能(AI)はコンピュータに予測をさせたり、問題解決のための決定をさせたりするコンピュータ科学の一部門だとAI4ALL(AIフォー・オール)が定義していますが、AIは医学の進歩から言語の翻訳アプリにいたるまで、すでに社会に一定の影響を及ぼしてきました。しかし、アマゾンの人材採用ツールが示したように、選択することをコンピュータに教える方法、いわゆる機械学習がコンピュータの機能の公正性に与えるインパクトは極めて重大なものなのです。

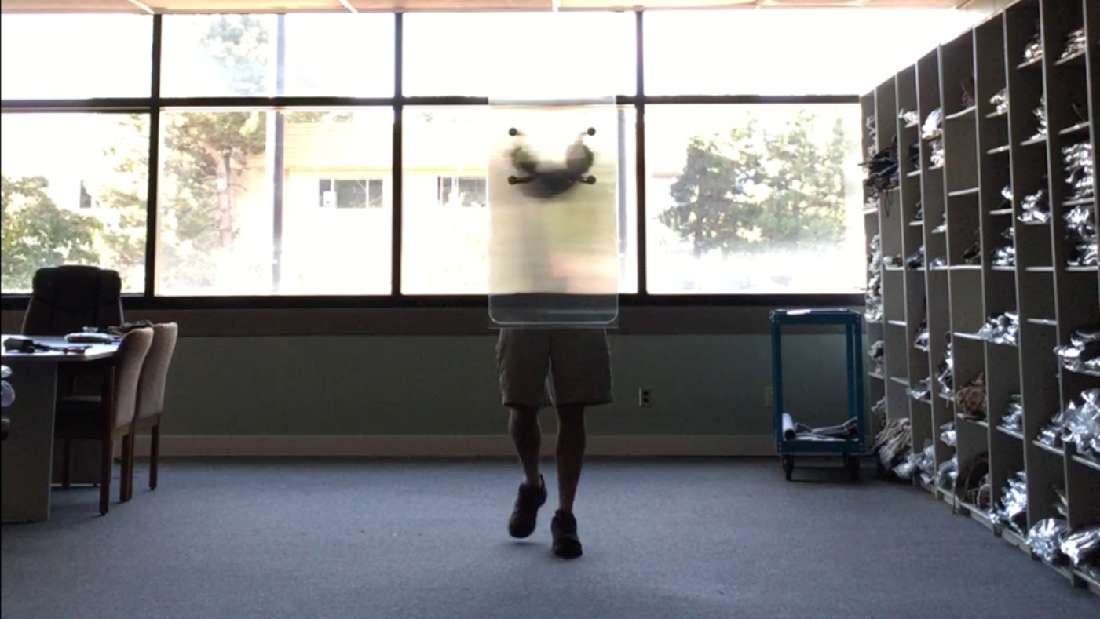

別の事例が顔認識の分野でもありました。米マサチューセッツ工科大学の研究員であり、コンピュータ・コードの詩人であるジョイ・ブォラムウィニ氏とグーグルでAIの倫理を研究する調査科学者、ティムニット・ゲブルー氏が入念に収集したデータを3つの商業用性別分類視覚システムに読み込ませ、精度をテストする共同研究を行いました。テスト結果は、比較的肌の色の濃い女性が最大34.7%という最も高い確率で誤判別されたグループとなり、比較的肌の色の薄い男性が誤って判別される確率は最大でも0.8%に留まりました。

顔認識ツールのようなAIシステムは警察などの社会の様々な分野で利用され始めているので、深刻な結果を招くことも考えられます。使用しているソフトウェアの間違いによって容疑者が誤認されるということもあるかもしれず、その場合、不当に告発されることになります。

多くのAIシステムに存在する有害な差別をなくすためには、システムが学ぶデータに改めて目を向ける必要があります。なぜなら、データは多くの点において社会に存在する偏見を反映しているからです。

2016年にある研究チームがワード・エンベディング(単語の分散表現)の使用を調査しました。ワード・エンベディングは機械学習において単語の意味と関係を知るための辞書のような働きをします。研究チームはAIが言語連想を行えるようにグーグル・ニュースの記事から得たデータを使って類推表現を生成する訓練をしました。たとえば、「『男』と『王』の関係は『女』と『X』の関係に相当する」の『X』をシステムは『女王』としました。ところが、「『男』と『コンピュータ・プログラマー』の関係は『女』と『X』の関係に相当する」という文章を提示されると『X』に『専業主婦』という言葉を選んだのです。

「『看護師』と『外科医』」というような女性と男性に関する他の類推表現でも、ワード・エンベディングが開発者の属する社会に存在する男女の固定観念を反映する偏見を含んでいることを示していました。「こういった言葉の連想は基本的な特徴として一般的に行われているので、ワード・ベディングはそのような類型化を反映するのみならず、増幅させることもあります」と研究チームの論文には書かれてあります。

また、AIの機械自体が有害な固定観念を存続させている面もあります。SiriやAlexa、Cortanaのような女性として設定されたバーチャル個人秘書は女性の役割を服従的で男性に対して副次的であるとする規範前提を再生産すると非難されてきました。性的に際どい問いかけに対するプログラム化した返答がこれをさらに強化しています。

南アフリカ・人文科学調査評議会の専門研究員、レイチェル・アダムズ氏によると、サムスンのバーチャル個人秘書であるBixbyを女性の声に設定して「ダーティな(卑猥な/泥で汚れた)話をしようよ」と語りかけると、返答は「サンタさんの悪い子リストに載ることになりたくありませんので」というものになります。それに対して、プログラムを男性の声に設定して同じ誘いかけをすると、返答は「土壌浸食はまさにダートな(泥土の)問題だと読んだことがあります」となります。

社会の男女に対する見方を変えるのはとてつもなく大きな課題ですが、この偏見がどのようにAIシステムに深くしみ込まされるのかを理解するとこのテクノロジーと共生する未来の役に立つかもしれません。プリンストン大学コンピュータサイエンス学部の助教であるオールガ・ラサコフスキー氏はこれらの問題を理解し、解決する方法について語っています。

「AIは世界中の非常にたくさんの人々に関わっており、このテクノロジーは私たちがどのように暮らし、働き、つながり合い、遊ぶのかということの多くの面にすでに影響を与えています」とラサフスキー氏は説明しています。「(けれども、)AIのアプリケーションに影響を受けている人々がこのテクノロジーを作ることに関与していないと、結果的に特定の集団のみが有利になるということがよく見られます。これはAIのモデルを訓練するために使われるデータセットに関連しているのかもしれませんが、AIが問題に取り組むために配備されている場合、その問題にも関連している可能性があります」

そのようなわけで、ラサフスキー氏の研究は3つの側面からAIの偏見に対処することに重点を置いています。3つの側面とはデータ、モデル、そして、システムを構築する人々です。

「データ面では、私たちが最近行ったプロジェクトで、ImageNetのデータセット(機械学習において物体認識のために使われる大規模な画像データセット)の公正性に関する問題を体系的に見つけ出し、修正しました。これらの問題は『人』のサブツリーにあるデータ収集プロセスが原因となって起きていました」とラサコフスキー氏は解説しています。

また、AIで使われるアルゴリズムにもラサコフスキー氏は注目しました。アルゴリズムはデータに存在する偏見を強化することがあるからです。ラサコフスキー氏は研究チームを主導して、畳み込みニューラルネットワーク(視覚心象を分析するために広く適用されているモデル)で偏見が増幅するのを防ぐためのアルゴリズム技法を明らかにし、その処理性能を評価するベンチマークテストにかけました。

AIに偏見を持たせる人間の役割に対処するということに関しては、ラサコフスキー氏はAIに「ダイバーシティとインクルージョン」(多様な人々が互いを認め合い、影響し合って、各人が能力を発揮する環境をつくること)を増やすことを目的とする財団法人AI4ALLを共同設立しました。「AIに必ず多様なグループの人々が参加するように計らうことによって、AIの影響に意義ある配慮をし、責任を持って利用するためのより良い立場に立つことができます」

研究機関Al Nowが、AIの全セクターにわたって多様性がまったく実現できていない現状を報告しています。主要なAIの学会に出席した論文著者のうち、女性は18%しかおらず、フィエスブックとグーグルで研究職に就いている女性は前者が15%、後者が10%です。また、グーグルでは黒人の社員が全社員の2.5%のみであり、フェイスブックとマイクロソフトにおいては4%に過ぎません。このことから、黒人女性はさらに疎外されている事実が浮かび上がってきます。

可能な限り多くのコミュニティの声がAIの分野に確実に反映されることが未来のために重要だとラサコフスキー氏は述べています。「コミュニティのメンバーたち自身がそのコミュニティが直面する問題を明らかにするのに最も適した立場にあるからです。そのコミュニティの一員ではない人は問題を見過ごしたり、不完全にしか理解できなかったりするかもしれません」

また、AIに関わる仕事をすることの意味をどのように認識するかということもこの分野に関与する人々の多様化に役立ちます。「倫理学者、為政者、法律家、生物学者、医師、コミュニケーターといった多様な分野の人々、いろいろな取り組み方をする人々が、責任を持ってAIを公正なものに開発できるように専門知識を提供することが必要です」とラサコフスキー氏。「それと同じくらい重要なのは、これらの役目を異なる経歴を持ち、異なるコミュニティに属する人々が担うことです。そのような人々が自分の目で見て経験している問題を反映するようなやり方でAIが構想されなくてはなりません」

行動を起こすのは今です。AIは第4次産業革命の最前線にあり、システムに埋め込まれた性差別と人種差別の意識のために特定の集団に過度に影響を及ぼすおそれがあります。完全に偏見のないAIをつくり出すのは不可能に思えるかもしれませんが、現在よりもはるかに巧みに行える能力を私たちは持っているのです。

「未来のAIに私が望むのは、多様なリーダーたちが集まった私たちのコミュニティが責任を持ってAIを利用し、社会的影響に配慮しながら先導して思慮深くこの分野を方向づけることです」と言ってラサコフスキー氏は締めくくりました。

reference:iflscience